Dans ce numéro, nous publions la première partie d’un dossier complet consacré au prompt engineering. La seconde partie paraîtra dans le prochain numéro de NETSOURCES

Ce dossier a pour objectif de vous accompagner dans la maîtrise du prompt engineering, discipline clé pour exploiter pleinement le potentiel des modèles de langage.

De la compréhension des mécanismes fondamentaux aux techniques les plus avancées, , ces deux articles constituent un guide complet pour maîtriser l’art du prompt engineering et tirer le meilleur parti des modèles de langage actuels et futurs.

Premier article : les fondamentaux du prompt engineering

Ce premier article récapitule les principes essentiels pour optimiser la formulation des prompts:

- Mécanismes internes des LLM : Rappel des processus clés - tokenisation (découpage du texte), embeddings vectoriels (représentation numérique) et architecture transformer (mécanismes d’attention) - pour comprendre comment les modèles traitent les prompts).

- Frameworks de structuration : Présentation de méthodologies structurantes combinant contexte, rôle et format de sortie, illustrées par des exemples concrets d’application.

- Techniques avancées : Exploration de méthodes sophistiquées comme les chaînes de pensées, ainsi que des techniques parfois méconnues comme l’utilisation de délimiteurs.

- Stratégie de longueur : Faut-il privilégier un prompt long et complet («méga-prompt») ou procéder par itérations successives ? La longueur optimale du prompt est une question cruciale.

Second article à venir : les techniques de pointe

- Méta-prompts vs méga-prompts : Exploration approfondie de ces deux stratégies avancées et analyse de leur distinction pour choisir l’approche optimale.

- Stratégies de pré-conditionnement : Maîtrise des techniques de pré-prompt

- Sécurisation : Découverte des protocoles de protection et mise en œuvre du prompt injection testing.

- Perspective d’avenir : Analyse prospective de l’optimisation des prompts dans l’écosystème GPT-5.

La qualité et la fiabilité des réponses fournies par un modèle de langage dépendent en partie de la formulation des consignes sous forme de prompt. À mesure que les grands modèles de langage (LLM) continuent de gagner en capacité et en complexité, à l’heure où ces LLM évoluent vers des modèles de raisonnement, et où GPT 5 fait son apparition, quelles sont aujourd’hui les bonnes pratiques de prompt pour la recherche d’informations stratégiques ? Commençons par rappeler quelques principes de base.

Tokens et embedding

Comment un prompt est-il « compris » par un modèle de langage ? Lorsque l’utilisateur saisit un prompt, le modèle de langage ne traite pas directement les mots entiers ; il découpe le texte en petites unités de 3 ou 4 caractères appelées « tokens ». La technique de l’« embedding » permet ensuite de transformer ces tokens en éléments sémantiques. À chaque token correspond un identifiant unique, sous forme de représentation numérique (ou vecteur) positionnée dans un espace à plusieurs dimensions. L’emplacement du token dans la phrase est également pris en compte via un codage de position, qui indique l’ordre des mots dans la séquence.

Les modèles de langage reposant sur les architectures Transformers mettent en œuvre également des mécanismes d’attention, afin de déterminer l’importance de chaque token par rapport aux autres dans la phrase. Ce mécanisme permet au modèle d’attribuer automatiquement un poids à chaque mot ou token, selon son importance dans le contexte global du texte.

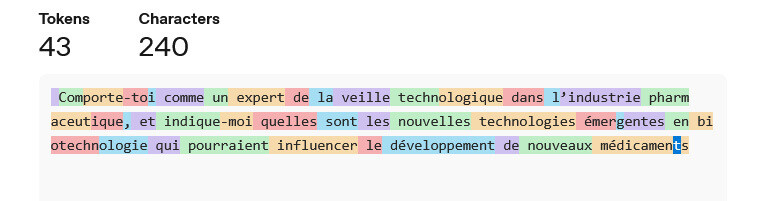

Printscreen : Un prompt transformé en tokens (via OpenAI Tokenizer)

La longueur maximale d’un prompt est mesurée en tokens. La quantité maximale de tokens que le modèle peut prendre en compte est appelée « fenêtre de contexte ». La limite totale inclut le prompt de l’utilisateur, les réponses précédentes dans la conversation et la réponse à venir. Cela équivaut généralement à environ 120 000 tokens, soit environ 80 000 mots. Cette fenêtre de contexte permet ainsi au modèle de langage de suivre le fil de la conversation, ou d’effectuer des actions à partir d’un même document.