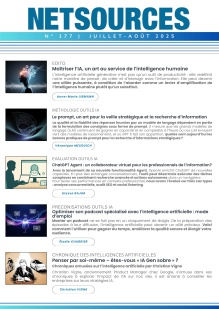

L’intelligence artificielle générative évolue à une vitesse vertigineuse, rendant la prospective à long terme particulièrement ardue. Pourtant, une convergence de signaux faibles récents - avancées techniques, annonces des laboratoires d’IA, avis d’experts - suggère une nouvelle phase d’accélération. Une course mondiale s’est engagée entre les principaux acteurs, chacun cherchant à définir la prochaine frontière de l’IA.

Cet article propose un état des lieux de cette compétition intense, des avancées technologiques attendues dans les prochains mois, et explore leurs implications immédiates pour les professionnels de l’information.