-

Vous êtes ici :

- Accueil

- Publications

- Netsources

Sélectionner le numéro de "Netsources" à afficher

Organisations Non-Gouvernementales : quelles ressources pour le veilleur ?

Les Organisations Non Gouvernementales (ONG) ont aujourd’hui plus que jamais une place majeure dans le paysage médiatique mondial.

En tant que sources, d’abord : leurs rapports, études et déclarations, relayées par la presse, font régulièrement l’objet de débats pouvant aller jusqu’au scandale. C’est ainsi que l’ONG International Council for Clean Transportation fut à la source de l’affaire des émissions de particules des véhicules diesel Volkswagen.

Les ONG sont aussi devenues un véritable enjeu pour de nombreux gouvernements qui, de la Hongrie à la Russie en passant par la Chine, voient ces dernières comme une potentielle source d’ingérence étrangère et cherchent à renforcer leur contrôle sur ces organisations.

Cette forte présence dans l’agenda médiatique fait logiquement des ONG une source d’intérêt pour le veilleur.

Mais avant toute chose, il convient de préciser le concept d’ONG qui regroupe plusieurs réalités.

ONG : comment les définir précisément ?

Le Conseil de l’Europe définissait dans un rapport de 2007 les ONG comme étant « des entités ou organisations autonomes volontaires créées pour réaliser les objectifs essentiellement non lucratifs de leurs fondateurs ou adhérents. Elles n’incluent pas les partis politiques. ». Est donc ONG toute organisation à but non lucratif ne relevant pas d’un gouvernement.

Une définition délicate à exploiter tant elle est large. Difficile, pourtant, de se montrer plus précis : en France, le statut juridique d’ONG n’existe pas, l’écrasante majorité de celles-ci étant en fait des associations loi 1901. Au niveau mondial, associations et fédérations sont d’ailleurs souvent (mais pas toujours) classées comme étant des ONG.

Des organisations, gouvernementales celles-ci, comme la Banque Mondiale ou l’ONU, se montrent un peu plus spécifiques en précisant que les ONG ont pour vocation de « défendre les intérêts des pauvres, protéger l’environnement, offrir des services sociaux de base » (Banque Mondiale) ou, plus généralement, « agir dans l’intérêt public » (ONU). Une ONG se différencie ainsi d’autres organisations privées par le fait qu’elle est fondée sur la défense d’une cause ou de valeurs spécifiques. Elle peut de plus être de type « opérationnel » (c’est-à-dire qu’elle est centrée sur la mise en place de projets spécifiques), ou de type « lobbyiste » (centrée sur la médiatisation de problématiques). D’autres organisations incluent aussi les think tanks et syndicats dans la catégorie des ONG, sans que cela soit systématique. Dans cet article, nous nous focaliserons sur la définition la plus commune des ONG, celle désignant les organisations engagées dans la défense d’une cause centrée sur l’intérêt public.

Nombreuses, parfois très influentes, au fait des agissements dans les pays ou sur les secteurs qu’elles couvrent, les ONG peuvent représenter une source d’information à ne pas négliger. Leur intégration dans une veille pose néanmoins un certain nombre de questions, certaines méthodologiques, certaines purement pratiques, auxquelles il convient de répondre afin d’exploiter au mieux les informations qu’elles possèdent.

Déjà abonné ? Connectez-vous...

Connexion

La Twittliste du secteur de la construction

Le secteur de la construction en France regroupe un nombre très large de corps de métiers différents : génie civil, travaux publics, logements, bureaux… que l’on retrouve sur la twittosphère.

Ce n’est pas étonnant au regard du poids que représente le secteur de la construction et du bâtiment en France et en Europe.

Après une baisse de 20% de l’activité depuis 8 ans, le marché connait une vraie dynamique, notamment dans la construction de logements neufs.

A titre d’exemple, au niveau national, on comptait 417 800 nouveaux permis de construire pour des logements, délivrés au cours de la dernière année.

Selon la Fédération française du bâtiment, en 2016, les activités dans le bâtiment ont connu une hausse de 1,9%, et l’organisation envisage une croissance de l’activité de 3,4% pour 2017.

Déjà abonné ? Connectez-vous...

Connexion

Sommaire janvier/février 2017

PANORAMA • Veille concurrentielle dans l’industrie : le cas des usines

SONDAGE • Les professionnels de l’information sont-ils encore les spécialistes des serveurs et bases de données professionnelles ?

OUTIL DE VEILLE • Brandwatch : une plateforme de veille qui allie puissance et flexibilité

AGENDA • I-expo 2017-02-10

SOURCES D’INFORMATION • Presse professionnelle : indispensable mais peu visible !

COMPLIANCE & DUE DILIGENCE • Compliance : les nouveaux défis stratégiques et informationnels pour les entreprises françaises

Déjà abonné ? Connectez-vous...

Connexion

Veille concurrentielle dans l’industrie : le cas des usines

Derrière les concepts de veille concurrentielle et de veille stratégique se cachent des réalités très diverses en fonction du secteur d’activité dans lesquelles elles s’exercent.

Dans l’industrie par exemple, la surveillance des usines des concurrents revêt un caractère crucial.

Elles ne représentent certes pas la partie la plus visible de l’entreprise, bien au contraire, mais sont au cœur des opérations et la recherche de tous types d’informations sur leur fonctionnement (production, éléments financiers, approvisionnement…) est essentielle dans l’analyse d’une société ou d’un groupe.

Très souvent en effet, la recherche de différents paramètres ou éléments divers que nous verrons plus loin sur les usines a pour but de pouvoir apprécier la rentabilité des opérations d’une société.

De plus, dans la mesure où les entreprises, en particulier les grandes, ne donnent pas accès aux éléments financiers de leurs différentes activités (segments ou business units), l’étude d’une usine peut permettre d’évaluer la performance de la société dans un secteur donné.

Enfin, une usine étant parfois exploitée par une entité juridique précise, il est dans ce cas plus facile d’appréhender cette unité juridique que la réalité financière d’une activité, noyée dans les comptes financiers globaux.

Nous avons donc choisi dans ce nouvel article méthodologique de nous focaliser exclusivement sur la veille concurrentielle appliquée aux usines, afin d’en présenter les spécificités, détailler les méthodes pour obtenir de l’information sur ces structures et les sources à connaître, tout cela agrémenté par une mise en pratique sur un fabricant d’électroménager.

Déjà abonné ? Connectez-vous...

Connexion

Brandwatch : une plateforme de veille qui allie puissance et flexibilité

Brandwatch est un acteur britannique spécialisé dans la veille et l’analyse sur les médias sociaux.

La société a été fondée en 2005 à Brighton mais la plateforme de veille Brandwatch Analytics a été lancée en 2007.

Depuis, l’entreprise s’est considérablement agrandie avec des bureaux à New-York, San Francisco, Berlin, Stuttgart, Singapour et, depuis peu, Paris, même si l’entreprise était déjà présente sur le marché français depuis quelques années avec des équipes francophones réparties entre Paris et Brighton.

Brandwatch propose trois produits distincts mais compatibles :

- Brandwatch Analytics une plateforme de veille sur les médias sociaux et d’analyse ;

- Brandwatch Vizia : une solution de surveillance des médias sociaux avec représentation des données en temps réel (utile par exemple dans le cadre de la surveillance des retombées d’un événement) ;

- Audiences : une base de données d’influenceurs qui compte plus de 300 millions de comptes Twitter.

Nous avons testé la plateforme Brandwatch Analytics et c’est à ce produit que nous allons consacrer cet article.

Brandwatch Analytics en bref

La plateforme surveille et indexe plus de 90 millions de sources en ligne.

Comme dans la très grande majorité des outils de veille, l’intégralité des sources surveillées sont des sources gratuites.

On y trouve :

- des sites d’actualités/presse en ligne, dans le monde entier

- des blogs (plusieurs millions),

- des forums (plusieurs centaines de milliers),

- des réseaux sociaux (Facebook, Twitter, Vkontakte, RenRen, Sina Weibo, Tencent Weibo, Taringa, Reddit, Digg, Xing, etc.).

- des vidéos (Dailymotion, YouTube, Vimeo),

- des images (Instagram notamment),

- des plateformes d’avis (Tripadvisor, CNET, etc.).

44 langues sont prises en compte dont le français, l’anglais ou encore le chinois et le russe mais la plateforme a également une fonction de recherche qui permet de travailler avec n’importe quelle langue.

On notera d’ailleurs que Brandwatch est partenaire officiel de Twitter, ce qui lui permet d’offrir l’intégralité des données de Twitter en temps réel mais également d’avoir accès à l’intégralité des archives depuis 2006.

Pour les autres réseaux sociaux, Brandwatch fait preuve de transparence en indiquant qu’il n’est pas possible de les couvrir à 100%, les différents acteurs imposant des restrictions. Pour LinkedIn par exemple, l’outil peut surveiller les blogs et forums d’aide mais pas les groupes ou les profils.

Brandwatch disposait jusqu’à peu d’un partenariat avec Datasift (voir Netsources n°122 - mai/juin 2016) mais y a renoncé. Rappelons que Datasift récupère grâce à un partenariat avec Facebook toutes les données publiées sur ce réseau social. L’objectif : permettre aux marques d’avoir un accès facilité à l’ensemble des données publiées sur Facebook (qu’elles soient publiées sur des comptes privés ou des pages ou groupes publics). Pour des questions de protection de vie privée, ces données sont anonymisées, mais offrent tout de même un accès à près de 65 attributs (sexe, âge, localisation...).

A la place de Datasift, Brandwatch va très probablement se tourner vers la nouvelle API Audience Insights développée et testée par Facebook. Brandwatch considère que cette API sera la seule stratégie de Facebook en ce qui concerne la mise à disposition de ses données.

Des fonctionnalités de recherche puissantes

L’un des points forts de l’outil repose dans sa capacité à créer des requêtes longues, précises et complexes. L’interface de création de requêtes n’est d’ailleurs pas sans rappeler celles d’agrégateurs de presse comme Factiva.

Figure 1. Interface de création de requêtes

On peut utiliser les opérateurs classiques AND, OR et NOT, les guillemets pour la recherche d’expression exacte et les parenthèses pour expliciter l’ordre de la recherche.

Mais les possibilités de recherche vont bien au delà de ce premier niveau avec des opérateurs avancés, finalement pas si éloignés de ce que peuvent proposer les agrégateurs de presse traditionnels :

- NEAR/x : pour retrouver un ou plusieurs termes à x mots maximums d’un autre par exemple :

(apple OR orange) NEAR/5 (smartphone OR phone) - NEAR/xf : pour retrouver un ou plusieurs termes à x mots maximums d’un autre en respectant l’ordre indiqué par exemple :

(prévisions NEAR/5f embauches) - title: pour rechercher dans le titre de la page uniquement

- author: pour rechercher dans le champ auteur quand il est disponible

- la troncature

*pour un nombre de caractères illimités et?pour remplacer un seul caractère - hashtags: pour rechercher spécifiquement des hashtags

- raw: pour respecter la casse d’un mot ou d’une expressionpar exemple :

raw:Totalpour rechercher uniquement le terme avec une majuscule ouNOT raw:RTpour éliminer les mentions contenant RT en majuscules et ainsi éliminer tous les retweets - site: pour délimiter la recherche à un (des) site(s) ou une(des) source(s)

- url: pour rechercher une url précise ou un mot contenu dans une url

- links: pour rechercher les mentions qui pointent vers un site ou une url précise. Fonctionne même quand l’url est raccourcie.

On peut également limiter la recherche à un continent, un pays, un état ou une ville.

Quand l’analyse rime avec la personnalisation

Toutes les plateformes de veille sur les médias sociaux proposent des solutions d’analyse mais on se retrouve souvent vite limité à quelques visualisations et graphiques. Chez Brandwatch, tout est personnalisable.

Une fois ses requêtes (Queries) créées, l’utilisateur va pouvoir visualiser les résultats dans ce que Brandwatch appelle des Dashboards . L’utilisateur peut choisir à partir d’un dashboard vide et d’ajouter les informations et éléments d’analyse qui l’intéressent ; il peut aussi partir de modèles existants (résumé des données importantes, focalisation sur Twitter, Facebook, mise en évidence des tendances, influenceurs, etc.).

Sur le modèle « résumé des données importantes », l’un des plus classiques, on trouve par exemple pour la période choisie :

- le nombre de mentions

- le nombre d’auteurs uniques

- les principaux sujets abordés

- les principales actualités sur le sujet

- des graphiques avec les mentions par jour, heures, etc

- une répartition des mentions par analyse du sentiment

- les sujets les plus abordés sur Twitter (éléments les plus tweetés, utilisateurs les plus actifs, hashtags les plus utilisés)

- évolution des sujets sur une période donnée

- listes et éléments démographiques sur les auteurs (basés sur des techniques complexes de machine learning qui analysent les biographies Twitter)

- graphiques sur la répartition par type de sources

- listes des principales sources d’actualités, forums ou blogs

- l’intégralité des mentions répondant à la requête.

On notera que chaque élément est cliquable et permet donc d’accéder aux mentions brutes d’un seul clic.

On peut également modifier chaque graphique en modifiant les axes (abscisses et ordonnées) du graphique ou bien en modifiant la période de recherche ou bien encore en filtrant le contenu selon différents critères (voir ci-dessous).

Autre point fort de ces dashboards : les nombreuses possibilités de filtres qui s’appliquent à tout le dashboard ou bien à un ou plusieurs éléments uniquement.

On peut ainsi filtrer les résultats par :

- sentiment ou type de résultats (actualités, images, Twitter, etc.) - on peut également exclure certains types de résultats ;

- auteur (nom de l’auteur ou bien limiter ou exclure une liste d’auteurs préalablement créée par l’utilisateur) ;

- éléments relatifs aux forums (nombre de posts au minimum/maximum, nombre de vues au minimum/maximum) ;

- éléments relatifs aux blogs (nombre de commentaires minimum/maximum) ;

- éléments relatifs à Twitter (nombre de retweets, nombre total de tweets, nombre de followers, nombre de personnes suivies, score d’influence, nombre d’impressions, compte vérifié, etc.) ;

- éléments relatifs à Instagram (type de mention, nombre d’interactions, nombre de « likes », nombre de commentaires, nombre de posts, nombre de followers, nombre de personnes suivies) ;

- éléments relatifs aux sites Web (mozrank (score de popularité), nombre de backlinks, limtation ou exclusion d’une liste de sites, nombre de visiteurs par mois, etc.) ;

- localisation (limitation ou exclusion de certains lieux) ;

- par tag ou catégorie (nous en reparlerons par la suite) ou exclusion de certains tags ou catégories.

Mise en pratique

Pour mieux comprendre le fonctionnement de l’outil, nous avons choisi de présenter le processus de mise en place d’une veille et d’analyse sur Brandwatch à travers un exemple concret.

Nous avons ainsi choisi de mettre en place une veille sur un grand acteur de l’électroménager Whirlpool en nous focalisant sur deux aspects distincts : d’une part les usines de Whirlpool avec un intérêt particulier pour certaines usines en Europe et d’autre part tout ce qui concerne plus largement la stratégie du groupe dans le monde entier (nominations, plans sociaux, vision stratégique, résultats financiers, etc.).

Tout débute par la création d’un projet que nous appellerons « Whirlpool ». Une fois le projet créé, l’utilisateur retrouve tous les éléments utiles pour la mise en place dans la colonne de gauche : dashboards, data, tools, reports, alerts.

Data pour la création des requêtes et surveillance

C’est dans l’onglet Data que nous allons créer les requêtes en choisissant l’option queries. Deux possibilités sont alors offertes : Query Wizard, un assistant à la création de requête adapté pout toutes les personnes peu familières des requêtes booléennes complexes et Query Editor, l’interface de création de requêtes booléennes traditionnelles. C’est ce dernier que nous avons choisi d’utiliser.

Nous avons ainsi créé deux requêtes, une pour les usines et une pour la stratégie générale du groupe.

Requête n°1 :

Whirlpool AND (Amiens OR Cassinetta OR Naples OR Napoli OR Proprad OR Sienne OR siena OR Trento OR Wroclaw OR manufacturing OR plant? OR usine* OR (site* NEAR/2 production*))

Requête n°2 :

Whirlpool AND (launch* OR lance* OR partnership* OR collaboration* OR partenariat* OR acquisition* OR agreement* OR acquire* OR purchase* OR rachat* OR rachet* OR innov* OR innovative* OR award* OR r?compense* OR invest* OR investi* OR financial* OR financier* OR nomination* OR appoint* OR nomm* OR announc* OR (job* NEAR/3 cut*) OR licencie* OR restructur*)

On visualise à ce stade les mentions répondant aux critères sur les 8 derniers jours, un graphique sur l’évolution des mentions, les principaux sujets abordés, les sites et auteurs les plus cités sur les 8 derniers jours. Cela permet d’estimer le volume d’information généré ainsi que la pertinence des résultats afin de pouvoir réorienter ci-besoin la requête. Cela peut être particulièrement utile pour les personnes disposant d’un abonnement avec une limite de mentions par mois.

On peut également choisir si l’on souhaite visualiser toutes les mentions répondant à la requête ou bien un panel aléatoire de 1 à 99 %, ce qui pourra limiter et réduire le volume d’informations généré chaque mois.

Toujours dans la rubrique Data, nous avons ensuite créé plusieurs Channels. Ces Channels permettent de mettre sous surveillance tout le contenu d’un compte Twitter public, une page Facebook publique ou un compte Instagram public. Nous avons ainsi mis sous surveillance les comptes Facebook et Twitter de plusieurs entités du groupe Whirlpool.

Nous avons ensuite créé un groupe regroupant la requête n°2 (sur la stratégie du groupe) avec les différentes Channels mises sous surveillance afin de pouvoir les utiliser d’un seul bloc par la suite.

Tools pour raffiner la surveillance

C’est dans la rubrique Tools que l’utilisateur va pouvoir affiner la surveillance et créer un certain nombre de filtres qui lui seront utiles lors de la visualisation des résultats.

Nous avons commencé par créer des listes de sites (Site lists) :

- une liste avec les sites institutionnels de l’entreprise Whirlpool (site du groupe, des différentes entités, blogs de l’entreprise, comptes Twitter, Facebook, etc.),

- une liste des sites, blogs, comptes sur les réseaux sociaux des organisations syndicales de l’entreprise,

- une liste de sources locales (presse locale, compte d’élus locaux, etc.) pour les usines qui nous intéressaient tout particulièrement en France, Italie et Pologne.

Cela nous permettra par la suite de visualiser ou d’exclure les mentions postées par l’entreprise elle-même, de visualiser uniquement en un clic les mentions relatives aux organisations syndicales ou encore de visualiser spécifiquement ce qui se dit sur Whirlpool dans les sources locales des usines qui nous intéressent le plus.

On notera qu’il est aussi possible de créer des location lists (pour limiter ou exclure les mentions provenant d’un ou plusieurs continent, pays, villes) et des authors lists (listes d’auteurs soit des journalistes, comptes Twitter, nom d’utilisateurs de forums, auteurs de blogs, employés etc.).

On peut ensuite créer des Categories et des Tags pour segmenter le contenu identifié par Brandwatch. Les tags sont plus simples à utiliser mais permettent moins d’actions que les catégories. C’est pour cette raison que nous avons choisi d’utiliser les catégories.

Nous en avons créé deux : une pour les usines avec les noms des villes où elles sont implantées et une pour les produits fabriqués par ces usines (lave-vaisselle, four, congélateur, etc.).

On peut ensuite manuellement ajouter ces catégories aux mentions récupérées ou bien créer des règles automatiques (appellées Rules). C’est ce que nous avons fait en indiquant par exemple à l’outil d’ajouter automatiquement la catégorie Usine et la sous-catégorie Amiens dès que le mot Amiens apparaissait dans une mention récupérée par les deux requête n°1 et 2 ou sur les différentes Channels créées. Nous avons créé ainsi une règle différente pour chaque usine.

Nous avons fait de même pour les produits électroménagers en créant par exemple la règle suivante : dès qu’un résultat contient les termes dishwasher* OR (lave? NEAR/2 vaisselle?) dans les requêtes n°1 ou 2 ou les différentes Channels, ajouter la catégorie Produit et la sous-catégorie Dishwasher.

Nous le verrons par la suite mais ces catégories seront très utiles lors de l’analyse et la visualisation des résultats.

Le dashboard pour l’analyse et la visualisation des résultats

Figure 2. Dashboard dédié à la stratégie sur les usines

Nous avons ensuite créé deux dashboards : un relatif aux usines (incluant la requête sur les usines) et un sur la stratégie du groupe (incluant la requête sur la stratégie et les différentes Channels). Nous avons choisi le modèle Summary pour avoir une vision globale des informations mais nous aurions également pu créer un dashboard complètement personnalisé ou utiliser des modèles qui se focalisent sur Twitter, Facebook, Instagram, etc.

Les informations présentées dans les dashboards sont nombreuses et permettent bien de faire ressortir les éléments importants. Dans notre exemple, on constate un pic de mentions le 24 janvier, date à laquelle Whirlpool a annoncé la fermeture de son usine d’Amiens.

On peut également modifier chaque graphique en modifiant les axes du graphique ou bien en modifiant la période de recherche ou encore en filtrant le contenu selon différents critères, par exemple en limitant ou en excluant les listes de sites (sites institutionnels de Whirlpool, organisations syndicales ou sites locaux) que nous avions créés précédemment.

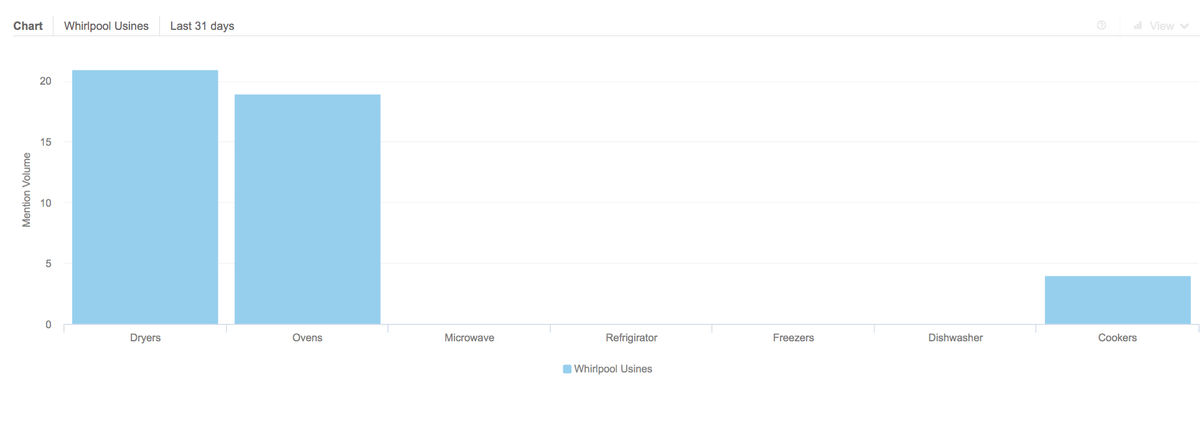

Figure 3. Graphique sur le volume d’informations pour la catégorie « produits » (fours, lave-vaisselle, etc.)

Nous avons ensuite rajouté un onglet en créant plusieurs graphiques pour analyser les contenus que nous avions catégorisés :

- un premier graphique permettant de voir le volume d’information généré sur le dernier mois sur les noms des usines. On constate alors que la majorité des mentions parlent d’Amiens et quelques mentions parlent de l’usine de Lodz mais aucune autre usine n’est mentionnée au cours des 30 derniers jours.

- Le second graphique permet de voir le volume d’informations relatif à chaque produit (lave-vaiselle, four, etc.) au cours des 30 derniers jours. On constate qu’il est surtout question des sèche-linges et des fours et dans une moindre mesure des cuisinières. Un clic sur chaque élément du graphique permet de visualiser instantanément les mentions.

Notons qu’il est aussi possible de croiser les catégories pour voir quel type de produit est le plus mentionné en rapport à quelle usine par exemple.

Reports et Alerts

Nous avons ensuite créé des Reports afin d’avoir un aperçu des résultats au quotidien. Les Reports sont des documents envoyés par mail chaque jour, chaque semaine, chaque mois ou chaque trimestre permettant soit d’avoir une vision globale de nouveautés, soit d’avoir une vision spécifique sur Twitter ou encore de comparer plusieurs requêtes entre elles.

Pour finir, nous avons mis en place des alertes intelligentes appelée Signals sur certaines requêtes et certaines catégories spécifiques afin d’être prévenu lorsque le volume d’information généré est inhabituel ainsi que des Customs Alerts complètement personnalisables pour, par exemple, recevoir une alerte lorsque le terme Amiens apparaît dans une mention mais uniquement sur la liste de sites des organisations syndicales que nous avions créée.

Notons enfin que tout ou partie des données peut être exportée sous différents formats.

Notre avis sur le produit

La couverture de sources proposée par Brandwatch est conforme à ce que l’on peut attendre d’un outil de veille sur les médias sociaux et les sources gratuites du Web. On appréciera d’ailleurs la présence de plusieurs réseaux sociaux locaux (notamment en Chine ou en Russie), ce qui n’est pas systématique pour les outils de veille de ce type.

L’intégration de sources payantes ou du moins l’intégration de données récupérées par l’utilisateur sur des sources payantes pour pouvoir les analyser serait évidemment un plus.

Les fonctionnalités de recherche sont puissantes et parmi les meilleures du marché et mêmes proches de certains agrégateurs de presse comme Factiva, Pressedd, LexisNexis, etc. Brandwatch réussit le pari de proposer un outil moderne de surveillance des médias sociaux tout en mettant en avant la valeur d’une recherche d’information complexe traditionnelle comme les professionnels de l’information l’affectionnent.

Les fonctionnalités d’analyse nous ont également séduits d’une part grâce à la force de la personnalisation mais également grâce à la puissance des filtres et notamment des catégories et tags.

Enfin, la capacité de Brandwatch à proposer des archives est un élément intéressant pour les professionnels de l’information souvent amenés à effectuer des recherches rétrospectives. Et cela s’avère généralement compliqué sur les médias sociaux.

Même si la couverture des archives n’est pas exhaustive, elle est au dessus de ce que peut proposer la concurrence : panel aléatoire de 10% des archives de Twitter depuis 2006 ou accès à l’intégralité des archives de Twitter jusqu’en 2006 (options payantes) et archives des sources indexées par Brandwatch sur les trois dernières années.

Abonnements

Brandwatch propose trois abonnements différents à sa plateforme Brandwatch Analytics : Pro, Enterprise M et Enterprise Q.

Les principales variantes entre ces différents abonnements se situent au niveau du nombre de mentions mensuelles inclus dans l’abonnement (de 10 000 mentions par mois à un nombre illimité) ou du nombre de Queries. Les données historiques permettant de faire des recherches rétrospectives et analyses (elles remontent sur 30 jours pour l’abonnement le moins cher et peuvent remonter sur 3 ans pour l’abonnement le plus cher et même 2006 pour Twitter en service payant additionnel).

Lien : www.brandwatch.com/fr

Presse professionnelle: indispensable mais peu visible !

Quand on pense recherche d’informations ou veille, ce qui vient en premier lieu à l’esprit pour identifier ou interroger des sources, c’est souvent la stratégie suivante :

. recherche sur le Web sur le sujet et notamment sur Google

. interrogation et surveillance des médias sociaux pour repérer des informations et des sources non trouvées sur le Web

. interrogation des grandes sources d’informations payantes comme les agrégateurs de presse ou les bases de données professionnelles (Factiva, EBSCO, etc) qui permettent d’accéder à une grande partie des informations payantes sur le Web.

En couvrant ces trois aspects, peu de chance a priori de passer à côté d’une information pertinente ? Pas si sûr...

Nous l’avons déjà vu au cours de précédents articles, il existe de nombreuses sources d’informations qui méritent d’être recherchées spécifiquement au risque de passer complètement à côté, si on se limite aux moteurs classiques comme Google. Nous avions déjà abordé le cas des collectivités locales et des think tanks (voir Netsources n°124 - septembre/octobre 2016). La presse professionnelle entre également dans cette catégorie.

Déjà abonné ? Connectez-vous...

Connexion

Compliance : les nouveaux défis stratégiques et informationnels pour les entreprises françaises

Dans un précédent numéro de Netsources (№ 124 septembre/octobre 2016), nous avons introduit la compliance et la due diligence en tant que composantes du spectre de l’intelligence économique.

L’évolution de la fonction de la compliance en France et le caractère de plus en plus stratégique des aspects organisationnel et informationnel, nous incitent à continuer et à approfondir notre réflexion. Il nous semble important de continuer à partager avec les professionnels de l’information ce sujet, qui par ailleurs émerge de plus en plus dans les problématiques d’informations traitées par FLA Consultants.

En effet, la nouvelle loi, dite « loi Sapin 2 » fixe très clairement des obligations et contraintes pour les entreprises en termes de conformité aux réglementations légales et financières, qui mettent au premier plan les enjeux informationnels et qui transformeront nécessairement le système d’information de l’entreprise.

En raison de la complexité de la question, et afin d’amorcer dans les meilleures conditions la réflexion sur cette dimension informationnelle et les perspectives de développement pour les professionnels de l’information, il nous paraît important de dresser tout d’abord, de la façon la plus précise possible, le cadre et le contenu de la nouvelle loi Sapin 2.

Les procédures anticorruption à établir selon la loi Sapin 2

La réglementation en termes de compliance s’est développée aux États-Unis avec le Federal Corrupt Practices Act 1977 (FCPA) puis par extension au reste du monde. La Grande Bretagne s’inspirant du FCPA a adopté le UK Bribery Act en 2010.

La France rattrape aujourd’hui un certain retard en matière de compliance avec la Loi Sapin 2.

Cette nouvelle loi relative à la transparence, à la lutte contre la corruption et à la modernisation de la vie économique, adoptée le 8 novembre 2016, introduit l’obligation pour toutes les entreprises ayant au moins 500 salariés et réalisant un chiffre d’affaires supérieur à 100 millions d’euros, de se doter de programmes de prévention des risques et de conformité impliquant le développement d’un système d’information interne et externe.

Cette loi s’inscrit dans le cadre d’une vague d’initiatives nationales qui visent à mettre à niveau la réglementation française selon le modèle international et notamment anglo-saxon, et qui prévoient d’imposer les programmes de compliance dans la gouvernance des entreprises.

Jusqu’à présent, les entreprises françaises pouvaient suivre les recommandations de l’OCDE au sujet de la corruption et devaient suivre les obligations existantes dans certains pays (notamment dans les pays anglo-saxons). Mais généralement, elles n’avaient pas l’obligation de mettre en place, en France même, des mesures concrètes pour prévenir le risque corruptif ou criminel, même si elles y étaient souvent exposées dans le cadre de leurs activités à l’international.

Un des principaux points de la loi est la création d’un organisme de contrôle, dénommée Agence française anti-corruption relevant du ministère de la justice et du ministère chargé du budget.

Les procédures organisationnelles à mettre en œuvre dans l’entreprise dans le cadre de cette loi se déclinent de la manière suivante :

- l’adoption d’un code de conduite décrivant les comportements à adopter caractérisés par des faits de corruption ou de trafic d’influence ;

- la mise en œuvre d’un dispositif d’alerte interne ;

- l’établissement d’une cartographie des risques ;

- la mise en œuvre d’une procédure de vérification de l’intégrité des clients, fournisseurs, partenaires et d’autres parties prenantes ;

- la réalisation de contrôles comptables internes ou externes ;

- l’instauration de sanctions disciplinaires permettant de sanctionner les employés, qui auront été préalablement formés, en cas de violation du code de conduite de la société1.

Ainsi le renforcement des exigences réglementaires de compliance fait peser de nouvelles responsabilités sur les entreprises françaises et leurs organes de gouvernance. Outre les sanctions disciplinaires sus-mentionnées, une peine complémentaire de mise en conformité touchera l’entreprise, et ses dirigeants, en cas d’absence de mise en place des procédures ci-dessus.

Ainsi, la mise en place de programmes de compliance peut donner du sens à l’action de chacun, dans un contexte où les risques ne sont plus seulement de nature financière mais aussi « réputationelle ».

Déjà abonné ? Connectez-vous...

Connexion

Sommaire novembre/décembre 2016

CAS D’ÉTUDE

• Alternatives à Google : est-ce vraiment utile ? pp. 1-5

OUTIL DE VEILLE

• Knowledge 360 : pleins feux sur la veille concurrentielle, pp. 6-9

FICHE PAYS

• Sources et ressources locales sur l’Indonésie, pp. 10-14

INDEX ANNÉE 2016

Déjà abonné ? Connectez-vous...

Connexion

Alternatives à Google : est-ce vraiment utile ?

Google est le leader incontesté des moteurs de recherche depuis maintenant de nombreuses années et personne ne semble en passe de le détrôner. Pourtant d’autres moteurs existent, survivent et disposent tout de même d’une certaine audience.

Lorsque nous devons réaliser une recherche d’informations ou une veille, notre premier réflexe sur le Web ouvert est évidemment Google mais y-a-t-il également un intérêt à interroger d’autres moteurs et les résultats proposés sont-ils proches ou identiques à ceux de Google ?

Nous parlons ici de moteurs de recherche généralistes comme Google et non de moteurs spécialisés (vidéos, images, thématiques, etc.) qui ont évidemment leurs propres spécificités.

On entend dire ici et là qu’il y aurait peu de recoupements entre les premières pages de résultats de Google et Bing, DuckduckGo, etc. Mais qu’en est-il vraiment ?

C’est ce que nous avons cherché à savoir en écrivant cet article. La comparaison est donc ici quantitative et non qualitative, l’idée étant de faire ressortir le nombre de résultats communs entre les moteurs plutôt que comparer la fiabilité et la pertinence des résultats proposés.

Nous nous interrogerons dans un premier temps sur l’intérêt d’aller sur d’autres moteurs et les cas où cela peut-être le plus utile. Nous listerons ensuite les principales alternatives au géant américain.

Enfin, nous avons décidé de réaliser trois recherches différentes sur Google et ses concurrents et de comparer la première page de résultats et les 100 premiers résultats afin de voir l’importance ou non du recoupement entre les différents moteurs.

Déjà abonné ? Connectez-vous...

Connexion

Knowledge360 : pleins feux sur la veille concurrentielle

Alors que se multiplient les solutions de veille « tout-en-un » certains acteurs préfèrent encore se focaliser sur un angle spécifique. C’est le cas de Knowledge360, une solution de veille dédiée à la surveillance de la concurrence.

Le choix n’est pas forcément surprenant : la veille concurrentielle est en effet, à tort ou à raison, souvent la pierre angulaire d’une stratégie de veille et son versant considéré comme le plus important par les décideurs.

Knowledge360 a lui l’ambition d’être une solution complète de surveillance des concurrents, en incluant bien sûr la veille mais aussi des solutions d’analyse.

Si Knowledge360 est relativement récent (sa première version est sortie en janvier 2016), la société américaine derrière cette solution, Cipher Systems, existe depuis 1996 et pratique l’intelligence économique au sens large, offrant des services de consulting en intelligence économique et analyse de marché.

Il est intéressant de constater que l’outil se veut très pragmatique et nous semble refléter les différences de sensibilité qui existent entre l’intelligence économique à la française, plus théorique, en quête d’exhaustivité des sources et plus centrée sur le process, et l’intelligence économique nord-américaine résolument pratique et orientée produit final avec des méthodes standardisées.

Focus sur les entreprises concurrentes

De par son positionnement sur la veille concurrentielle, l’interface de base présente ainsi les informations d’une société concurrente, dont la teneur peut être modifiée librement par l’utilisateur grâce à un système de widgets : affichage des résultats financiers de la société, dernières actualités ou offres d’emplois en rapport avec cette société, ou encore derniers changements de dirigeants.

Pour ce faire, Knowledge360 dispose d’une base de données d’entreprises qui inclue, d’après l’un des directeurs de Cipher Systems Beau Oliver « toutes les sociétés faisant plus de 100 millions de dollars de profit », grâce à un partenariat avec la base de données financière FactSet. Rappelons que Facset est un acteur important de l’information financière qui existe depuis 1978 et fournit en temps réel des données du marché, des nouvelles, des analyses des entreprises et industries et des simulations de portefeuille.

Knowledge360 nous a indiqué disposer de près de 500 000 sources.

En plus des informations sociétés issues de Factset, l’outil propose de nombreuses sources de presse. Knowledge360 a ainsi recours à plusieurs agrégateurs de presse ainsi que ses propres agrégateurs propriétaires.

Knowledge360 comporte également un volet médias sociaux permettant de suivre de près l’actualité des entreprises sur Twitter et Youtube. Le suivi des réseaux sociaux est néanmoins relativement limité par rapport à ce que proposent d’autres solutions : il n’est pas possible de réaliser des recherches complexes ou de recevoir d’importantes masses de données, mais simplement de suivre une poignée de comptes.

Enfin, Knowledge360 offre la possibilité de surveiller blogs et forums : cette fonction n’est pas activée par défaut (« car elle n’intéresserait pas la plupart des sociétés », selon le directeur du développement) mais peut l’être sur simple demande.

Parmi les fonctionnalités plus originales, on trouve la surveillance et la cartographie des offres d’emplois d’une société. Celle-ci est basée à la fois sur des sites d’offres d’emplois ainsi que sur les offres publiées sur les sites des sociétés elles-mêmes. Les offres d’emplois peuvent représenter un signal faible très pertinent (d’autant plus lorsqu’elles sont géolocalisées, comme c’est le cas ici) et la fonctionnalité est donc très intéressante.

Cette interface, avec une présentation des informations par société n’empêche pas pour autant de surveiller plus largement une industrie toute entière. De plus, il est également possible, grâce aux fonctionnalités que nous présenterons par la suite, de surveiller des entreprises de plus petites tailles et notamment des PME.

L’interface est divisée en plusieurs grandes sections : Dashboards, Knowledge, Analysis et Report

Déjà abonné ? Connectez-vous...

Connexion

Les Tags de Netsources

- IA

- brevets

- cartographie

- SEO

- open access

- livrables de veille

- humain

- médias sociaux

- sourcing veille

- flux RSS

- professionnel de l'information

- open data

- recherche vocale

- information business

- agrégateurs de presse

- à lire

- conférences salons

- information scientifique et technique

- outils de recherche

- outils de veille

- tendances

- multimédia

- actualités

- méthodologie

- serveur de bases de données

- curation

- due diligence

- recherche visuelle

- outils de traduction

- fake news

- fact checking

- publicité

- géolocalisation

- marques

- appels d'offres

- sommaire

- formation Veille Infodoc

- retour d'expérience

- OSINT

- propriété intellectuelle

- presse en ligne

- recherche Web

- évaluation outils

- références bibliographiques

- résumé automatique

- Bing

- veille collaborative

- veille audiovisuelle

- veille innovation

- infobésité

- études de marché

- données statistiques

- dataviz

- information financière

- LexisNexis

- Newsdesk

- sourcing pays

- veille medias

- veille commerciale

- réseaux sociaux

- newsletter

- veille à l'International

- ist

- ChatGPT

- veille métier

- intelligence économique

- veille concurrentielle

- podcast

- science ouverte

- open source

- veille technologique

- knowledge management

- édito

- Intelligence artificielle

- navigateur IA

- sécurité informatique

- navigateur agentique

- méthodologie et livrables