-

Vous êtes ici :

- Accueil

- Publications

- Bases

Sélectionner le numéro de "Bases" à afficher

Les périls et la puissance du NOT dans la stimulation des chatbots

Nous avons le plaisir d’accueillir dans nos colonnes Marydee Ojala, professionnelle de l’information américaine très connue. Elle est rédactrice en chef de la revue ONLINE SEARCHER.

Nous avons adapté pour BASES l’article de Marydee, précédemment publié dans sa version originale en anglais dans la section ONLINE SEARCHER du numéro 5, volume 44, paru en juin 2024 de la revue COMPUTERS IN LIBRARIES sous le titre « The perils and power of NOT in prompting Chatbots » dans la rubrique « Voices of the searchers »

La plupart des professionnels de l’information connaissent bien les commandes booléennes de base : AND, OR et NOT. Elles fonctionnent parfaitement pour la recherche dans les bases de données traditionnelles. Lorsque nous enseignons les techniques de recherche, nous nous appuyons sur des exemples et des diagrammes de Venn pour démontrer la puissance de la recherche booléenne. J’ai toujours pensé que nous devrions souligner les dangers de la commande NOT, en particulier dans les ressources en texte intégral proposant des documents volumineux.

Il est facile pour les chercheurs novices de penser que, puisqu’ils ne s’intéressent qu’à un seul concept dans une recherche, exclure quelque chose qu’ils perçoivent comme non pertinent est une bonne manière d’obtenir les meilleurs résultats. Cela n’est pas toujours vrai. Prenez un exemple trivial pour illustrer le potentiel danger du NOT. Vous voulez des informations sur les allergies des chiens. Mais les allergies des chats ne vous intéressent pas. Vous entrez alors «allergies AND (dogs NOT cats)» de manière «intelligente». Cela exclut automatiquement un document très pertinent qui contient la phrase : «Contrairement aux allergies des chats, les allergies des chiens sont causées par les protéines Can F.»

En revanche, la commande NOT fonctionne bien dans les bases de données traditionnelles lorsque vous construisez des ensembles. Vous pouvez alors exclure un ensemble contenant des informations déjà consultées, éliminant ainsi les redondances et conservant les informations potentiellement pertinentes. Cela illustre la puissance du NOT.

Déjà abonné ? Connectez-vous...

Connexion

Utiliser la force prédictive de l’IA pour l’analyse

Le battage médiatique autour de l’IA générative a quelque peu éclipsé les avancées tout aussi décisives de l’IA prédictive dans les domaines de la recherche et de la veille d’informations. Pourtant, la première n’aurait pas rencontré un accueil aussi favorable dans les entreprises sans l’expérience de la seconde qui opère déjà, depuis des années, une transformation en profondeur de nos pratiques professionnelles.

Depuis qu’il est devenu possible pour tous d’interroger des intelligences artificielles dans un langage naturel, on parle beaucoup de l’impact de l’IA générative pour les métiers de l’information (voir notre article « Search: quand les moteurs “recherchent pour vous” », Bases N° 425 - mai 2024).

Mais cette dernière n’est pas arrivée en terrain vierge. Il est donc temps de remettre en lumière l’IA prédictive pour replacer l’apport des modèles de langage dans une perspective plus juste au sein des métiers info-documentaires.

En explorant les deux domaines, on comprend que si l’IA générative produit du contenu (images, musique, textes, vidéos) à partir d’un ensemble de données d’entraînement (invisibles pour l’utilisateur), l’IA prédictive, elle, en tire des conclusions. En détectant des modèles et des signaux dans ces mêmes données, celle-ci contribue à anticiper des tendances, des comportements ou des événements à venir. Il peut s’agir du contenu à « pousser » à l’utilisateur ou d’une tendance qui va amener à commercialiser le produit correspondant. Techniquement parlant, l’IA générative utilise elle-même de nombreux processus prédictifs pour prédire le contenu à générer.

Les apports de l’IA prédictive

Basée sur des techniques d’apprentissage automatique (machine learning) et des algorithmes statistiques, son niveau d’analyse lui permet d’aller bien au-delà des simples statistiques descriptives. L’IA prédictive est potentiellement présente dans chaque phase de nos métiers.

- En phase de recherche et de collecte avec :

• Les suggestions de recherche de Google,

• La personnalisation des flux d’information sur YouTube ou les médias sociaux (Facebook, Instagram, TikTok)

• Les recommandations de contenus similaires ou connexes sur Amazon ou dans les médias (en suivant la logique « si vous avez aimé ceci, alors vous aimerez cela »)

• La vérification de plagiat ou de génération IA (texte, audio ou vidéo)

Déjà abonné ? Connectez-vous...

Connexion

ACCES LIBRE - Le droit d’auteur face à l’IA générative : Interview de Philippe Masseron (gf2i) sur les enjeux juridiques et économiques des métiers de l’information et de la donnée

Philippe Masseron du gf2i (Groupement français de l’industrie de l’information) nous éclaire sur les enjeux cruciaux du droit d’auteur à l’ère de l’IA générative. Entre risques de prédation massive des contenus et opportunités d’accès et d’innovation portées par l’IA, les acteurs de la création et de l’information doivent se mobiliser pour défendre leurs intérêts et repenser leurs modèles de valorisation.

Le rôle d’instances comme le gf2i sera clé pour peser dans les débats législatifs en cours et créer les nouveaux équilibres dans l’économie de la donnée.

Philippe MASSERON

Expert en droit de la propriété littéraire et artistique et en gestion de droits

Après des études juridiques (DEA en Finances publiques et Fiscalité – Paris 2) et en Information Communication (Institut Français de Presse – Paris 2), Philippe MASSERON a successivement occupé les postes de directeur juridique et directeur général au CFC (Centre Français d'exploitation du droit de Copie).

Il est administrateur du gf2i (Groupement Français de Industries de l'Information) délégué à la prospective. Il participe régulièrement aux missions du CSPLA.

Anne-Marie Libmann (AML) : Comment définissez-vous le problème de fond sur la question du droit d’auteur par rapport aux systèmes d’intelligence artificielle générative (SIAG) ?

Philippe Masseron (PM) : Nous assistons à une réaccélération et une amplification massive du phénomène de scraping, fouille et crawling des données. Cela n’est pas nouveau, nous avons déjà été confrontés à des situations similaires par le passé qui ont suscité de vives inquiétudes, comme lors du lancement de Google Books ou des grands programmes de numérisation des bibliothèques. Mais l’échelle et la vitesse ont changé. Aujourd’hui, il existe d’immenses bases de contenus protégés accessibles, notamment dans le domaine scientifique, par exemple SciHub qui rassemble des millions de documents en infraction avec le droit d’auteur.

Le problème posé par les IA génératives se situe à deux niveaux. En amont, il y a l’exploitation des œuvres existantes pour entraîner les modèles. En aval se pose la question de la protection par le droit d’auteur des productions de ces IA. Aux États-Unis, le Copyright Office a refusé d’attribuer un copyright à la plupart des créations d’IA qui lui ont été soumises. En Europe, il n’y a pas encore de jurisprudence établie. Mais il y a un risque évident de destruction massive de valeur et de concurrence déloyale pour les industries culturelles. Imaginez un livre généré par une IA et vendu sur Amazon qui bénéficierait de tous les avantages fiscaux et juridiques du livre sans rémunérer les auteurs dont les œuvres auraient servi à son entraînement.

AML : Peut-on considérer que les productions issues d’IA entraînées sur des contenus non autorisés relèvent d’une forme de recel ? Cette question se pose par exemple pour les livrables de veille réalisés par les services de veille et analyse, ou encore cabinets de conseil spécialisés dans la veille et l’intelligence économique. Existe-t-il un risque juridique ?

PM : C’est une question complexe qui mérite d’être creusée, mais je n’ai pas de réponse définitive à ce stade. La qualification de recel suppose un élément intentionnel. Poudrait-il démontrer que l’utilisateur de l’IA avait conscience que les données d’entraînement contenaient des œuvres protégées ? Il faudrait aussi être en mesure d’identifier précisément les œuvres utilisées, ce qui n’est pas évident au vu des nombreuses copies et des transformations subies.

Des techniques existent déjà pour détecter les contenus générés par IA, notamment dans le monde éducatif qui est confronté au plagiat. Mais elles ont leurs limites. Le principe de transparence figurant dans le projet d’AI Act européen se veut une réponse, mais il est insuffisant, car il ne descend pas au niveau de l’identification d’œuvres individuelles au sein des jeux de données d’entraînement.

En l’état, la charge de la protection pèse donc principalement sur les ayants droit qui doivent s’équiper d’outils de détection, de marquage et de traçage. C’est coûteux et chronophage. L’opt-out massif est une étape primordiale pour poser des barrières juridiques et ouvrir la voie à des négociations avec les exploitants d’IA. Certains grands médias comme Le Monde ont déjà conclu des accords avec OpenAI, mais la portée et le contenu de ces deals restent confidentiels.

AML : Comment pèsera la question du référencement des sources utilisées par les IA dans les chatbots et moteurs de recherche ? Si le référencement progresse dans le bon sens, ne risque-t-on pas de réduire le problème de la juste rémunération au débat classique entre visibilité et monétisation des contenus, avec au final une perte significative dans la valorisation du travail des éditeurs de contenus ?

PM : C’est même pire que cela, car la convergence qui s’opère entre IA et moteurs de recherche, notamment chez Google, fait peser un risque majeur sur le trafic des éditeurs de contenus. Si les liens de Google sont de plus en plus souvent servis par de l’IA au détriment des sites sources, cela pourrait avoir des conséquences dramatiques sur l’audience et donc le modèle économique des éditeurs qui en dépendent à 80 % ou plus.

D’où l’importance de l’opt-out massif et des barrières juridiques, même si on peut penser que Google aura les moyens techniques de contourner en alimentant son IA par d’autres biais. Les éditeurs doivent aussi investir urgemment dans les outils d’analyse de logs, de marquage et de traçage des contenus, même si le coût est élevé. Cet investissement devra être pris en compte dans les futures négociations de licences.

Une action collective, portée par exemple par les organismes de gestion collective, serait sans doute profitable pour mutualiser les coûts et peser dans les rapports de force. Mais c’est compliqué dans la presse où la culture de la gestion collective est peu développée, contrairement à d’autres secteurs comme la musique. Chacun préfère souvent négocier dans son coin, les plus gros ayant les moyens de conclure des deals individuels.

AML : L’IA n’est-elle pas le révélateur d’une crise de longue date de la propriété intellectuelle liée au Web et médias sociaux, avec le pillage des données initié par Google, puis amplifié par les réseaux sociaux sur les données personnelles ou encore LinkedIn sur les données professionnelles ?

PM : Il était difficile d’avoir une vision claire dès le départ. Les éditeurs se sont longtemps sentis coincés entre leur besoin de visibilité apportée par le référencement et la protection de leurs contenus. Avec l’effondrement progressif des revenus publicitaires, le rapport de force a changé, mais il était sans doute déjà trop tard. L' IA marque une étape supplémentaire dans ce phénomène prédateur, mais on ne peut pas dire qu’elle le fait naître. C’est une forme d’accélération et de changement d’échelle, permise par la numérisation massive de ces dernières décennies et la concentration du secteur numérique autour de quelques très grands acteurs capables de se lancer dans une course à l’armement technologique.

AML : Quels risques et opportunités voyez-vous pour les métiers de l’information (journalistes, veilleurs, documentalistes…), notamment sur la problématique du droit d’auteur lié aux résumés automatisés et autres « productions artificielles » ?

PM : Je ne pense pas que l’IA changera fondamentalement la donne, mais il faut être vigilant. Pour les professionnels de l’information, c’est surtout une opportunité, car les outils d’IA vont permettre d’automatiser toute une partie du travail de tri, de classification et de synthèse de l’information. La valeur ajoutée se déplacera encore plus vers la pertinence de la sélection, la qualité de l’analyse et de la mise en perspective.Il ne faut donc pas rejeter l’IA, mais réfléchir à la complémentarité intelligente avec le facteur humain. La question du résumé automatique, et de son statut par rapport au droit d’auteur de l’œuvre originale, n’est pas nouvelle. Le résumé ne permet pas, en principe, de se passer du document primaire s’il est bien fait. C’est un vieux débat, comme celui sur l’impact des panoramas de presse qui n’ont finalement pas fait disparaître les abonnements.

De même, le métier de documentaliste est toujours là malgré la disparition des centres de documentation physiques dans beaucoup d’organisations. La fonction s’est transformée et décentralisée au sein des équipes, au plus près des métiers, mais elle reste indispensable. Le vrai défi est de gérer l’infobésité croissante et d’extraire de la valeur de la masse exponentielle des données. L’IA peut aider à relever ce défi.

AML : Pouvez-vous décrire le rôle et actions du gf2i pour défendre les intérêts des acteurs de l’industrie de l’information dans ce contexte de bouleversement ?

PM : Le gf2i a vocation à sensibiliser ses membres aux enjeux et à promouvoir l’émergence de marchés pour les différents types de données, au-delà des seuls contenus éditoriaux.

L’enjeu majeur pour nous est de structurer de véritables marchés pour les différents types de données. Des embryons existent déjà, mais tous les acteurs n’en ont pas encore pleinement conscience. Le mouvement de l’open data a un peu brouillé les pistes, avec des effets positifs en termes d’accès, mais aussi un appauvrissement côté public, avec une perte de qualité par manque de moyens pour maintenir et mettre à jour les jeux de données ouverts.

AML : Comment structurer de véritables marchés de données ?

PM : L’enjeu porte sur tous les domaines : données juridiques, géographiques, de santé, financières, etc. C’est un immense défi de structuration qui nécessite de trouver les bons modèles économiques et les bonnes formules de licences adaptées aux différents maillons de la chaîne de valeur. Le droit d’auteur a toute sa place, mais il faut aussi valoriser les investissements dans la qualité, la mise à jour, l’enrichissement, le croisement des données.

En ce sens, un service de veille et de documentation interne peut aussi se penser comme un producteur de données à valoriser, pas seulement comme un consommateur. C’est un changement de perspective à opérer.

En conclusion, on voit que malgré les bouleversements technologiques, les questions de fond sur la protection et la valorisation des données et des contenus restent assez similaires. Le gf2i est mobilisé de longue date sur ces enjeux et entend bien continuer à peser dans les débats actuels, comme dans le cadre des missions en cours du CSPLA (Conseil Supérieur de la Propriété Littéraire et Artistique) et de la mission parlementaire sur ces sujets. Il en va de la survie de pans entiers de l’économie de l’immatériel.

Scopus AI : une nouvelle façon de rechercher dans SCOPUS avec l’intelligence artificielle

La plateforme Scopus propose depuis longtemps des outils de recherche classiques : opérateurs booléens, et de proximité, navigation dans les citants/cités. Les fonctionnalités apportées par Scopus AI permettent d’expérimenter de nouvelles stratégies.

Tous les serveurs/agrégateurs présents sur le marché sont en train d’intégrer plus ou moins rapidement des fonctionnalités d’intelligence artificielle. Ils le font souvent en proposant à des bêta-testeurs, souvent des clients importants, de les aider à finaliser la mise au point de ces nouvelles fonctionnalités. D’autres, et ce n’est pas incompatible, mettent progressivement à disposition des séries d’outils innovants.

Nous ouvrons une rubrique dédiée à l’IA chez les grands serveurs de bases de données. Et nous commencerons cette série d’articles par Scopus AI, la nouvelle offre qu’Elsevier est en train de développer et qui est toujours en bêta.

Les caractéristiques de Scopus AI

Scopus AI s’appuie exclusivement sur le contenu de Scopus, c’est-à-dire sur les abstracts (donc pas les textes intégraux des documents) sur lesquels il a été entraîné. Pour le moment les documents pris en compte ne remontent pas plus loin que 1973. Il est nécessaire d’avoir accès à la plateforme Scopus pour accéder à Scopus AI.

Le contenu de Scopus

Rappelons que Scopus met à disposition plus de 91 millions de documents publiés depuis 1788, les références n’étant prises en compte que depuis 1970. Les documents référencés sont de différentes natures, essentiellement articles, comptes-rendus de conférences et chapitres d’ouvrages.

Accéder à Scopus AI

Poser une question

L’accès à Scopus AI se fait par un onglet sur l’écran d’accueil de Scopus. On est alors invité à poser une question dans la boîte de recherche. Scopus AI utilise une combinaison de technologies, certaines provenant d’Elsevier et d’autres non. Il utilise en particulier une combinaison de ses propres LLM (Large Language Model) avec d’autres, dont le modèle GPT développé par OpenAI. Mais il est précisé que cet usage est strictement privé et qu’il n’y a aucun échange d’information pouvant servir à entraîner GPT.

Le multilinguisme

La question se pose naturellement en anglais compte tenu du fait que les abstracts présents dans Scopus sont en anglais, mais des projets sont prévus pour développer le multilinguisme qui fonctionne déjà au moins en partie puisque nous avons posé une question en français qui a été parfaitement comprise et pour laquelle la réponse a été en anglais.

La structure de la réponse

Cette réponse est constituée de plusieurs éléments. On trouve un bref résumé suivi de plusieurs paragraphes qui sont autant de thématiques composant la réponse renvoyant chacune à des références sans abstract situées dans la partie droite de l’écran. Suit, enfin, une rapide conclusion indiquant, le cas échéant quelles questions n’ont pas trouvé de réponse satisfaisante. On peut à cette étape obtenir jusqu’à dix références.

Les documents fondamentaux

Déjà abonné ? Connectez-vous...

Connexion

Search : quand les moteurs « recherchent pour vous »

Entre les annonces de Google et d’OpenAI, l’utilisation de l’IA dans la recherche redessine irrémédiablement les pratiques sur Internet. Aux agrégateurs traditionnels comme les moteurs de recherche et les médias sociaux, s’ajoutent donc les moteurs avec IA. Pour les veilleurs, le challenge se déplace de la synthèse à la vérification des résultats de recherche.

Il y a quelques jours, OpenAI volait la vedette à Google qui présentait pourtant sa Keynote, événement phare des groupes de la tech. La rumeur, qu’Open AI ne s’est pas empressé de démentir, annonçait le lancement de son propre moteur de recherche. Finalement, ce dernier a (en attendant?) présenté un nouveau modèle gratuit qui intègre le web et les GPTs, des fonctionnalités jusqu’alors payantes (environ 20 €/mois). Si l’on ajoute la liste d’accords de licences avec les médias qui s’allonge chaque semaine, on comprend que l’ambition de ce dernier est réelle et se veut à la hauteur des attentes.

Les utilisateurs utilisent en effet les chats d’IA comme des moteurs de recherche et y font leurs recherches malgré le risque d’hallucination. La recherche d’informations fait ainsi partie des usages inattendus des modèles de langage, créés à l’origine pour deviner des suites de phrases. D’après une étude de The Verge, 53 % des utilisateurs et 61 % des Millenials utilisent les chats IA plutôt que les moteurs de recherche traditionnels pour faire leurs recherches.

Une recherche sans liens…

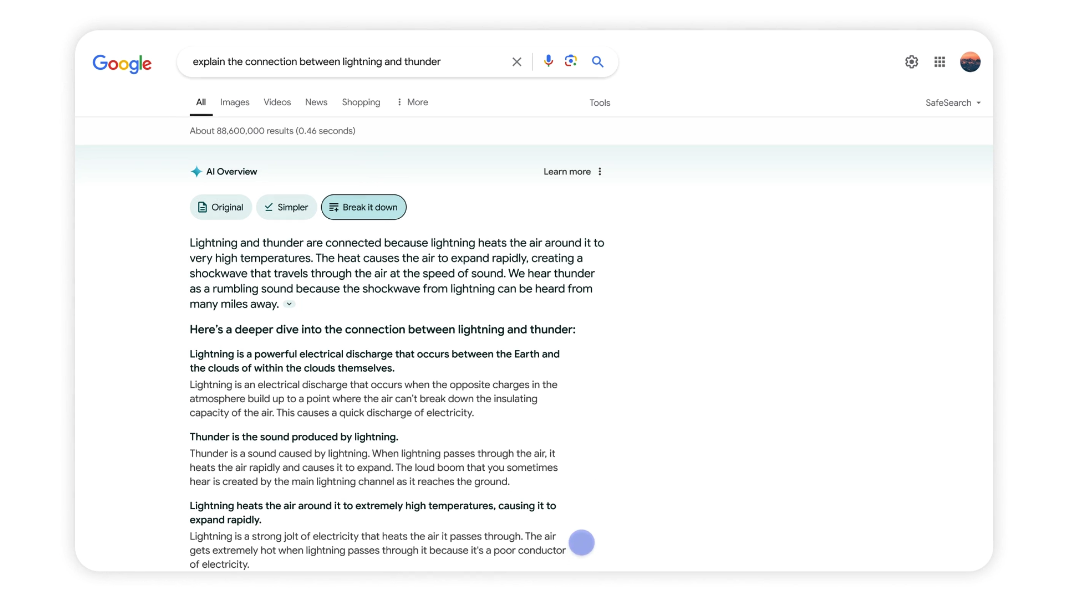

De son côté, Google, qui représente encore près de 87 % de part de marché dans le monde, a annoncé le futur de Google SGE, son moteur de recherche enrichi à l’IA. Il s’appelle « AI Overviews » (« Aperçus IA ») et pourrait être disponible en France à la fin de l’année 2024. Cette version, qui utilise Gemini pour comprendre les requêtes, propose un résumé des résultats de recherche, notamment pour les recherches les plus complexes, ainsi que d’autres innovations comme les réponses sous forme d’images ou la catégorisation des résultats de recherche.

Mais surtout, Google présente son futur moteur comme suit : « Google fera la recherche sur Google pour vous ». Ce qui n’est pas sans rappeler la fonctionnalité « Browse for Me » (Recherche pour moi) du navigateur Arc (voir notre article Search : Arc ouvre la voie à de nouvelles pratiques de recherche, BASES N° 424, avril 2024). Mais si Google prévoit d’ajouter quelques liens à ses résumés de requêtes pour « aller plus loin », l’utilisation d’Arc a déjà montré aux utilisateurs français à quel point cliquer sur ceux-ci devient… inutile, voire superflu, y compris pour le professionnel de l’information.

Figure 1 : Avec Google Overviews, les résultats de recherche « aperçus » fournis par IA disposent de trois niveaux de réponse différents : original, simplifié ou développé.

Après « un monde sans sources » (voir notre article IA : la veille dans un monde sans sources, BASES N° 416, juillet 2023), le veilleur découvre donc un monde sans liens (ou presque), voire « sans clic », puisque les résultats disparaissent de la première page de recherche.

Certes, à la liste de liens à parcourir et à lire, succède donc une réponse immédiate, personnalisée. De quoi mettre fin à la surabondance de l’information par des résultats fournis sous forme de synthèse composée des sources (rarement identifiés) ayant servi à alimenter l’IA. Cela constitue aussi moins de saisie, moins d’onglets et plus de discussions avec un moteur de recherche.

… et sans sites internet ?

Jusqu’à présent, l’écosystème de Google constituait un point d’entrée d’internet basé sur des liens vers le contenu des éditeurs. Et comme Google reste de loin la plus grande source de trafic sur le Web aujourd’hui, s’il « garde ce trafic pour lui-même » en répondant aux questions avec l’IA, ou « s’il remplace le web par lui-même », comme le notent certains observateurs américains, il est susceptible changer l’écosystème tel que nous le connaissons.

Déjà abonné ? Connectez-vous...

Connexion

La pérennité en question des informations sur le web

Deux études récentes révèlent que la durabilité des informations sur le web est loin d’être garantie.

La première traite des liens DOI et montre qu’environ 27 % des documents ne sont pas conservés dans des archives pérennes. La seconde étude indique que 25 % des pages web créées il y a dix ans ont disparu, et de nombreux liens sur ces pages sont brisés. Ces résultats mettent en lumière les défis de la préservation de l’information numérique à long terme.

C’est un grand changement si on se réfère à l’ère du papier qui a débuté en 1 450 et a duré environ cinq siècles sans partage. En effet, pendant cette période, le support papier pour l’information paraissait relativement éternel préservé au moins pendant très longtemps dans les bibliothèques sauf incident majeur tel qu’un incendie ou les conséquences d’un conflit armé.

Les deux études récentes que nous allons présenter portent sur l'accessibilité de l'information sur le web. Elles montrent que la possibilité de se connecter pour accéder à ces informations a une fâcheuse tendance à diminuer à mesure que le temps passe.

La première étude est consacrée à la pérennité des liens attachés à un DOI (digital object identifier), très souvent un article scientifique tandis que la seconde s’est attachée d’une part à l’accessibilité dans la durée des pages web et, d’autre part à la pérennité des liens présents dans une page web.

Plusieurs millions d’articles deviendraient inaccessibles sur Internet

L’analyse à partir des DOIs

Tous les documents sous forme électronique (articles, comptes rendus de conférences, ouvrages…) se voient attribuer depuis 1998 un numéro de DOI (digital object identifier) de même que certains documents imprimés, même publiés avant 1998.

Ce DOI est le plus souvent attribué par l’éditeur, mais, par exemple pour un preprint l’auteur cherchera une archive qui attribue des DOIs.

Le DOI est une suite de caractères alphanumériques commençant par « 10. ». Il est lié de façon définitive au document auquel il est rattaché quels que soient ses mouvements, et même en cas de disparition de l’éditeur.

L’International DOI Foundation attribue à chaque « DOI registration agency » un préfixe unique qui vient après le « 10. ».

Chaque agence fournit ensuite à ses organisations membres (éditeurs, sociétés savantes…) des DOIs à attribuer à leurs publications (articles, livres, jeux de données…) intégrant son préfixe.

Ces agences gèrent un système de « résolution » de DOI permettant de faire le lien entre un DOI et l’emplacement en ligne de la ressource identifiée même si elle a été déplacée.

Les principales agences d’enregistrements de DOIs sont CROSSREF pour les publications académiques, DataCite pour les jeux de données de recherche, EIDR (Entertainment Identifier Registry) pour les films, les émissions de télévision, les enregistrements de spectacles, les podcasts et autres documents audiovisuels d’intérêt commercial ou culturel.

Il existe aussi des agences à vocation plus territoriales comme KISTI (Korean DOI Center) pour la Corée du Sud, CNKI (China National Knowledge Infrastructure) pour la Chine, ce dernier proposant également une banque de données de publications scientifiques chinoises.

Une recherche à partir de Crossref

Martin EVE, un chercheur de l’université anglaise de BIRBECK à Londres qui travaille aussi pour Crossref en tant que « principal R&D developer » s’est interrogé sur la réelle pérennité des liens permettant, à partir d’un DOI, d’accéder au document (1).

Méthodologie :

L’auteur a considéré que, pour garantir un accès pérenne au document, il était préférable qu’il soit présent dans plusieurs archives (instances de préservation).

Il a mené une étude en avril 2023 à partir des documents dont les DOIs sont attribués par des membres de Crossref.

Comme il n’était pas question de travailler sur les 144 millions de documents concernés, il a extrait de façon aléatoire 1 000 DOIs issus de chaque membre, ce qui l’a conduit à un total de près de 7,5 millions de DOIs.

Le professeur Eve a d’abord considéré qu’un document avait plus de chances d’être retrouvé dans le futur s’il était stocké dans plusieurs archives.

En définissant un critère relativement complexe, il a constaté que seul un petit nombre, soit 204 membres de Crossref, soit 0, 96 % préservaient au moins 75 % de leurs documents dans au moins trois archives. On trouvera dans l’article de cet auteur d’autres mesures selon des critères analogues et détaille des résultats inquiétants.

Déjà abonné ? Connectez-vous...

Connexion

ResearchGate développe ses liens avec les éditeurs

ResearchGate est un réseau social consacré aux chercheurs leur permettant d’échanger entre eux sur différentes questions et de partager leurs publications.

Récemment ResearchGate a signé des accords avec de nombreux éditeurs offrant ainsi un contenu de plus en plus important, avec, malheureusement des possibilités de recherche très limitées.

ResearchGate multiplie depuis quelques mois les annonces de partenariat avec des éditeurs scientifiques.

Cette stratégie peut être décomposée en deux volets :

• La mise en ligne d’articles, essentiellement en open access, de nombreux éditeurs;

• D’autre part, des accords particuliers confidentiels avec Elsevier et ACS (American Chemical Society) signés en fin de l’année dernière.

La mise en ligne de nouveaux contenus open access d’un grand nombre d’éditeurs

Le premier volet est donc le chargement sur la plateforme ResearchGate des contenus de nombreux éditeurs, et pas les moindres.

On peut, en effet, citer, rien que pour les quatre premiers mois de 2024 : Trans Tech Publications (7 titres), SAGE (100 titres), Cambridge University Press (16 titres), Taylor & Francis (400 titres), Wiley (700 titres), Optica Publishing (105 000 articles depuis 2012). Pour sa part, l’accord avec Emerald Journals (18 titres) date de juillet 2023.

Ces contenus sont principalement en open access. Pour les articles payants, le système vérifie quels sont les droits d’accès de l’utilisateur liés à son affiliation académique s’il en a une. Il peut aussi demander directement à l’auteur une copie à usage privé, mais l’expérience montre que si l’on n’a pas une adresse mail montrant sans ambiguïté que l’on appartient au monde académique on n’a pratiquement aucune chance d’obtenir une réponse positive de l’auteur.

Restent donc, le cas échéant, l'outil Unpaywall, les bibliothèques, les sites d’éditeurs, ou, pour les entreprises, les fournisseurs de documents primaires comme Reprints Desk aux États-Unis.

Les accords signés avec Elsevier et ACS

Ces accords ont été signés fin 2023 entre ACS et Elsevier d’une part et ResearchGate d’autre part. Ils mettent un terme aux poursuites qui avaient été engagées depuis 2007 par ces deux éditeurs.

Ce qu’on comprend de ces accords particuliers et confidentiels, c’est qu’au moment du téléchargement d’un article par un auteur sur le site, une vérification automatique est effectuée pour identifier les différentes possibilités de partage disponibles.

Un changement radical de relation avec les éditeurs

Les relations avec les éditeurs n’ont pas été un long fleuve tranquille (cf. notre article « ResearchGate contraint de supprimer 200 000 articles », Bases N° 396 - oct 2021). Une nouvelle politique a initiée vis-à-vis d’eux en 2022, selon le rapport financier relatif à cette année-là (le dernier disponible).

Déjà abonné ? Connectez-vous...

Connexion

Faire ses recherches avec un GPT

Utiliser un assistant IA monotâche comme les GPTs d’OpenAI permet d’utiliser un modèle de langage dans un but spécifique et de façon plus précise qu’avec un chatbot généraliste comme ChatGPT, Gemini ou Copilot. Nous en avons testé une vingtaine dédiés à la recherche et voici les résultats de notre sélection.

Les agents virtuels ne sont pas simplement capables de converser et de guider l’utilisateur comme un chatbot, mais ils peuvent aussi adapter leurs réponses au contexte et à l’intention de celui-ci.

Les plus connus sont les GPTs d’OpenAI, même si d’autres agents sont apparus comme les Hugging Chat Assistants de Hugging Face et les copilotes de Microsoft.

Mais les GPTs d’OpenAI, d’après nos tests, restent les plus opérationnels. Attention, ils ne sont toutefois disponibles qu’avec la version payante GPT Plus, pour un résultat qui reste inégal.

Consensus, l’as de la recherche scientifique

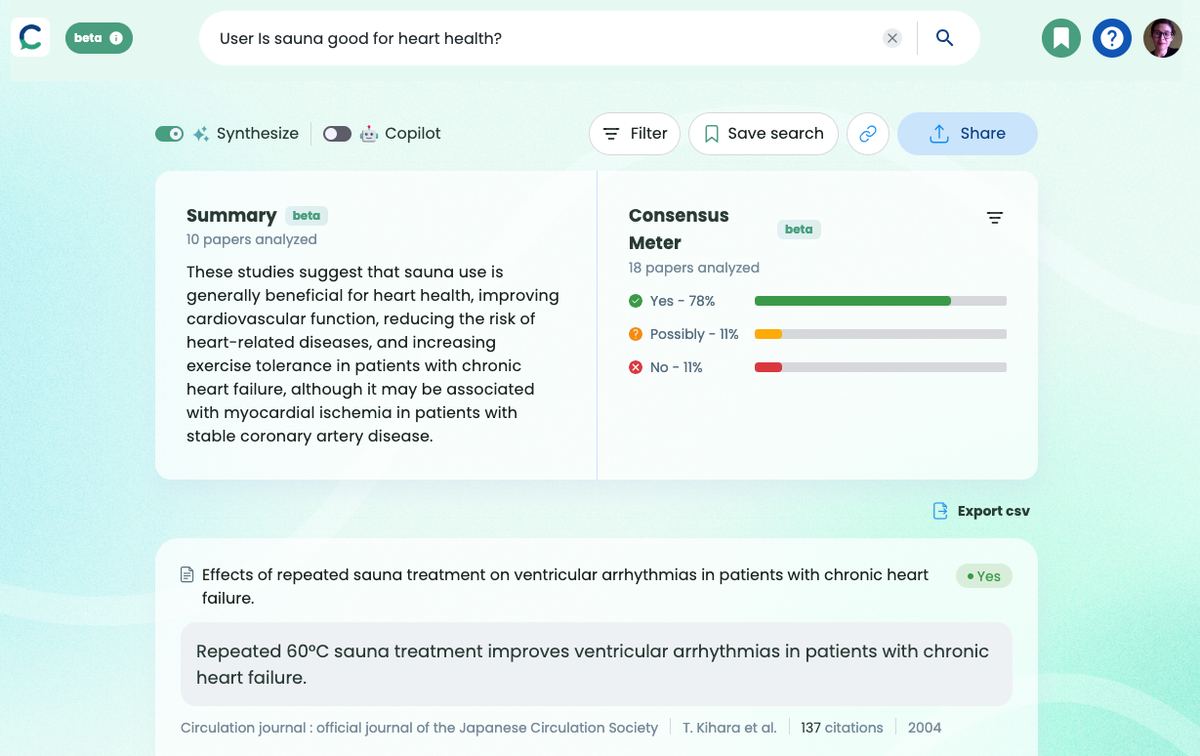

Consensus intègre intelligemment la capacité d’analyse des IA pour l’appliquer à la recherche d’articles scientifiques. L’outil existe sous forme de GPT à utiliser avec ChatGPT et sous forme de plateforme (https://consensus.app/) à part entière pour une utilisation plus complète. Pour le retrouver dans le GPT Store, il faut se rendre sur « Explorer les GPTs » dans la barre de gauche, puis taper directement le mot-clé Consensus.

Quel que soit le point d’entrée, le fonctionnement général est le même : on pose une question précise dans la barre de dialogue, comme « Le sauna est-il bon pour la santé ? » ou « la méditation peut-elle modifier notre cerveau ? » et Consensus s’applique à retrouver la réponse, avec un niveau de précision inédit. Pour juger de sa fiabilité, cette réponse est constituée des extraits issus des sources identifiées par un lien qui renvoie à la plateforme Consensus (voir Figure 1).

Figure 1 : Les résultats du GPT Consensus sont présentés sous forme de synthèse avec des exergues qui dirigent vers les sources.

Sur la plateforme, les extraits permettent de trouver rapidement si le document est pertinent et pointent vers l’endroit où l’extrait se situe précisément dans l’article scientifique (un gain de temps inestimable !). De plus, un bouton Study snapshot donne un descriptif rapide de la méthodologie des recherches de chaque article cité (échantillon, etc.) afin de pouvoir en juger en un clin d’œil.

Enfin, une fonctionnalité de synthèse fonctionne également pour les questions fermées. Dans ce cas, la réponse est analysée sous forme de pourcentage du nombre d’études qui penchent en faveur de « oui » et « non » ou « possible », en plus d’un résumé des réponses (voir Figure 1 bis). Enfin, la recherche peut être approfondie à l’aide de nombreux filtres comme : les échantillons ou la réputation de la revue. En revanche, il est nécessaire de filtrer les résultats par dates afin d’obtenir les dernières études.

Figure 1bis : Les résultats de la plateforme Consensus… nettement plus complets que son GPT.

Alimenté par les quelque 200 millions d’articles académiques de Semantic Scholar, Consensus est mis à jour régulièrement. À noter, l’historique archivé sur OpenAI reste aléatoire et n’apparaît pas à la connexion suivante du GPT, contrairement à la plateforme, qui permet d’archiver recherches et articles, même en version gratuite. La plateforme, disponible avec une version gratuite, permet d’ailleurs de s’affranchir de l’abonnement payant à ChatGPT, puisqu’elle propose un nombre de recherches illimité et quelques crédits pour utiliser l’IA.

Déjà abonné ? Connectez-vous...

Connexion

Search : Arc ouvre la voie à de nouvelles pratiques de recherche

La nouvelle fonctionnalité de recherche IA « Browse for Me » du navigateur Arc n’est disponible que sur iPhone et elle fait déjà grand bruit.

Non seulement elle a été rapidement adoptée par les utilisateurs, mais la presse y voit une fonctionnalité qui réinvente la façon de s’informer… et pourrait être le pire cauchemar des éditeurs.

Pour les professionnels de la veille, son impact pourrait bien aller au-delà du Search.

Disponible depuis quelques mois sur Windows après avoir été adopté par les utilisateurs de Mac (voir notre article « Arc browser réinvente la navigation en ligne », BASES N° 420, décembre 2023), le navigateur Arc vient à nouveau d’attirer l’attention du monde de la tech avec sa nouvelle fonctionnalité « Browse for Me » (que l’on pourrait traduire en français par « cherche pour moi »).

Disponible uniquement sur les iPhones actuellement, le bouton « Browse for Me » apparaît au cours de l’écriture dans la barre de recherche (voir Figure 1).

Figure 1 : La fonctionnalité « Browse for Me » apparaît au cours de l’écriture dans la barre de recherche.

Pour s’informer des dernières actualités, on peut rédiger une invite simple, de type : « quelle est l’actualité internationale aujourd’hui en France ? » ou « quelle est l’actualité du secteur cosmétique aujourd’hui en France ? », Arc fournit une liste factuelle, composée de résumés générés par IA (voir Figures 2 et 3).

Exit la liste de liens qui renvoient vers des articles payants, les autorisations de cookies, les publicités et autres boutons d’abonnement… En bref, tout ce qui fait obstacle à l’information brute.

Figures 2 et 3 : Les premiers résultats apparaissent sous forme d’une liste de résumés d’une phrase (on peut cliquer sur des liens proposés au-dessus de la liste, sous forme de snippets)

Lorsqu’une requête est effectuée, Arc explore le contenu des médias en ligne, le résume et… consent à laisser quelques liens en haut et en bas de la réponse. Mais il n’y a fondamentalement plus besoin de cliquer puisque la réponse est déjà fournie.

Et au lieu d’apparaître sous forme d’une liste de liens sur lesquels cliquer pour obtenir des bribes de réponses comme sur Google ou de chat comme sur Copilot, Arc propose une page web personnalisée selon les requêtes de recherche et générée par IA : sous une première liste des grands titres de l’actualité, des sous-sections apparaissent (voir le résultat de notre requête en cliquant sur ce lien, même si vous n’êtes pas doté du navigateur ou de l’app).

Déjà abonné ? Connectez-vous...

Connexion

Les statistiques au service de la stratégie documentaire

Qu’il s’agisse du pilotage, de la valorisation ou de la communication de l’activité documentaire, comment les fonctionnalités statistiques de ces outils aident le documentaliste à tirer le meilleur parti de ses outils numériques ?

En documentation, nous avons recours à divers outils numériques pour accompagner nos activités, diffuser nos produits ou offrir des abonnements adaptés à nos utilisateurs.

Ces outils ne sont pas utilisés de la même façon selon la mission du service, la période de l’année et le type d’utilisateurs visés.

Grâce à l’analyse statistique, il est possible d’en tirer le meilleur parti en fonction de son propre usage. Voici trois exemples concrets, tirés de trois types d’outils différents.

Les outils de pilotage interne

L’analyse des statistiques fournies par les outils de gestion des fournisseurs d’information, les outils métier comme les logiciels documentaires ou un Système intégré de gestion de bibliothèque (SIBG) ou encore les outils de diffusion, permettent aux services d’information d’adapter leur offre de produits et services documentaires à leurs utilisateurs.

Par exemple, l’analyse de statistiques des bases de données proposées par Factiva, Orbis, Dalloz, etc. apporte un éclairage sur l’utilisation de leurs contenus comme le taux de consultation ou de téléchargement des informations.

Compte tenu de leur coût d’abonnement souvent très élevé, le service d’information doit évaluer les statistiques de ces outils afin de garantir leur rentabilité. En fonction des chiffres recueillis, plusieurs conclusions peuvent être tirées et un plan d’action être établi.

Que la ressource soit sous-exploitée ou au contraire surexploitée, il faudra en comprendre les raisons : les utilisateurs connaissent-ils l’existence de l’outil ? Savent-ils s’en servir correctement ? Rencontrent-ils des difficultés de connexion ? L’outil répond-il à leurs besoins ?

Ces statistiques apportent ainsi autant d’informations nécessaires pour décider de façon éclairée de l’arrêt de l’abonnement ou au contraire de l’augmentation du « forfait » de mener une campagne de communication ou encore d’organiser des sessions de formation.

Déjà abonné ? Connectez-vous...

Connexion

Les Tags de Bases

- IA

- brevets

- cartographie

- SEO

- open access

- livrables de veille

- humain

- médias sociaux

- moteurs académiques

- revues académiques

- sourcing veille

- flux RSS

- professionnel de l'information

- dirigeant

- open data

- recherche vocale

- information business

- agrégateurs de presse

- à lire

- conférences salons

- information scientifique et technique

- outils de recherche

- outils de veille

- tendances

- multimédia

- actualités

- méthodologie

- serveur de bases de données

- curation

- due diligence

- recherche visuelle

- outils de traduction

- fake news

- fact checking

- publicité

- géolocalisation

- marques

- appels d'offres

- sommaire

- formation Veille Infodoc

- retour d'expérience

- OSINT

- agenda

- propriété intellectuelle

- presse en ligne

- recherche Web

- évaluation outils

- biomédical

- Questel

- Dialog

- références bibliographiques

- thèses

- résumé automatique

- Bing

- open citation

- Scopus

- veille collaborative

- outsourcing

- veille audiovisuelle

- veille innovation

- infobésité

- études de marché

- données statistiques

- dataviz

- information financière

- Corée du Sud

- Pressedd

- LexisNexis

- Newsdesk

- sourcing pays

- chimie

- e-réputation

- recherche publique

- droit d'auteur

- littérature grise

- archives ouvertes

- veille medias

- dark web

- veille commerciale

- trésor du web

- réseaux sociaux

- veille à l'International

- ist

- ChatGPT

- veille métier

- intelligence économique

- veille concurrentielle

- Bluesky

- podcast

- dark social

- shadow social

- science ouverte

- open source

- veille technologique

- knowledge management

- littérature scientifique

- web of science

- derwent

- abstracts

- protocole

- Intelligence artificielle

- OpenAI

- Commerce conversationnel

- GEO

- veille automatisée

- agents conversationnels

- recherche biomédicale

- veille informationnelle

- Afrique