Le cas particulier de Wikipédia

Si Wikipédia n’appartient pas aux GAFAM, il détient tout de même une place particulière sur le Web et faire figure de géant pour tout ce qui a trait aux définitions. De plus, il entretient des liens très étroits avec Google.

Google fait régulièrement des dons à la fondation Wikimédia, Il y a quelques semaines, Wikipédia a annoncé un partenariat avec Google pour intégrer Google Translate pour la traduction des pages de l’encyclopédie, etc.

Pour Google, Wikipédia c’est un peu la caution anti fake news dont il avait besoin. Il utilise des informations Wikipédia dans le Knowledge Graph, cet encadré à droite des résultats qui compilent différentes informations (définitions d’un concept, fiche sur une personnalité, une entreprise, etc.). Il est assez rare d’effectuer une recherche sur Google (à moins que cela concerne un sujet très spécifique ou de niche) sans tomber sur un résultat issu de Wikipédia sur la première page quand ce n’est pas directement dans le featured snippet.

Car aujourd’hui, Wikipédia est considéré par tous ou presque comme une source fiable et de qualité, ce qui n’était pas le cas à ses débuts dans les années 2000. L’idée d’une encyclopédie collaborative alimentée par des internautes qui n’étaient pas nécessairement des experts reconnus en a effrayé plus d’un. Dans les années 2000, il était ainsi mal vu d’utiliser et citer des définitions Wikipédia dans ses travaux scolaires et universitaires.

Mais avec le temps, Wikipédia a su démontrer que des contenus produits par des internautes, à condition d’avoir des règles précises et un véritable processus de validation, vérification et citations des sources pouvaient avoir une réelle valeur.

Une source considérée comme non-fiable à un instant T peut ainsi devenir fiable avec le temps et l’inverse est également vrai.

Néanmoins, comme partout sur le Web, Wikipédia n’est jamais à l’abri d’héberger des fake news, des fausses informations ou simplement des contenus à vocation publicitaire. On pensera ainsi à ce récent scandale où l’entreprise d’équipement sportif North Face a remplacé des images de paysage sur l’encyclopédie par ses propres images où son logo est bien visible.

Notre avis

Si la visibilité des sites et contenus douteux est indéniablement en baisse sur Google, ce qui est une bonne nouvelle, cela ne change finalement pas grand-chose pour les professionnels de l’information qui ne se sont jamais contentés du premier résultat ni de la première page de résultats pour réaliser une recherche ou une veille.

Néanmoins si le but de la veille et de la recherche est d’identifier des infox, fausses informations, sites douteux, sites de contrefaçons, etc., il y a désormais moins de chance de les identifier en passant par Google.

Méfiance cependant : si la qualité s’est améliorée sur le moteur de Google, Google News ou encore YouTube, il semblerait que ce soit l’inverse sur Google Alertes. Christophe Deschamps ou Serge Courrier signalaient ainsi récemment sur leurs comptes Twitter que les alertes Googleétaient de plus en plus polluées par des résultats provenant de vrais-faux sites web redirigeant vers des chaines de pages publicitaires ou remplis de malwares.

Microsoft s’associe à une start-up pour lutter contre la désinformation

Comme Google, Bing s’est également penché sur la question de la désinformation.

En 2017, il avait suivi les pas de Google en proposant des labels de fact-checking accolés à certains articles et sites d’information.

Et c’est Bing qui avait été le premier à annoncer des résultats en position 0 (l’équivalent des featured snippets de Google) agrégeant plusieurs résultats afin de faire émerger différents points de vue notamment contradictoires.

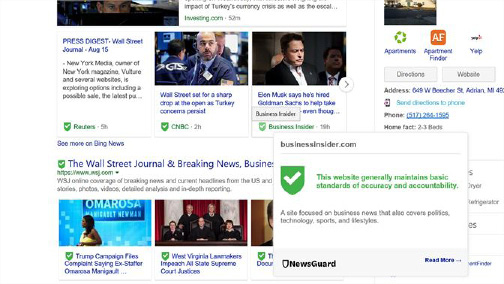

Plus récemment, en janvier dernier, Microsoft a encore innové avec une autre approche : l’installation par défaut dans son navigateur Edge du plugin Newsguard (voir figure 1.) sur mobile uniquement, qui veut lutter contre la désinformation en attribuant une note à chaque média. Si l’application est installée par défaut, c’est néanmoins à l’internaute de l’activer.

Figure 1. Newsguard utilisé dans le navigateur Edge

Nous aurons l’occasion d’aborder à nouveau plus loin la question du développement des plugins et extensions de navigateurs pour évaluer les sources et l’information.

Facebook : du mieux mais...

Facebook a longtemps été pointé du doigt depuis 2016 pour ne pas avoir su enrayer ce phénomène de Fake News et même souvent pour avoir rendu possibles sa naissance et sa croissance exponentielle.

Depuis maintenant quelques années, Facebook fait désormais appel à des fact-checkers extérieurs (partenariats avec éditeurs de presse en France par exemple) pour vérifier l’information et signaler tout contenu faux, douteux ou illicite. Il utilise parallèlement un système automatique à base de machine learning.

Plusieurs études semblent montrer que cette stratégie est payante et que la qualité et fiabilité des contenus sont en hausse. Cependant, on a pu voir ces dernier mois plusieurs articles où des fact-checkers se plaignaient du manque de moyen et de l’impossibilité de faire face au déluge de Fake News tout en s’interrogeant sur les motivations réelles et le sérieux de Facebook dans sa lutte (ADN quand tu nous tiens…).

Notre avis

Bien que regorgeant de contenus, Facebook est un outil qui pose un réel problème pour les professionnels de l’information quand ils ont à l’utiliser. Fort heureusement, il n’a souvent d’intérêt que sur des recherches sur des personnes ou dans un contexte de veille d’image.

Son moteur de recherche interne est de piètre qualité et l’on ne sait jamais vraiment pourquoi tels résultats ressortent plutôt que d’autres et quel est le volume réel d’information relatif à une requête comparé à ce qu’il veut bien nous montrer.

Dans de précédents numéros de NETSOURCES, nous avions eu l’occasion de mentionner plusieurs outils de recherche externes à Facebook bien plus performants mais Facebook a choisi il y a quelques jours de changer de stratégie et la très grande majorité de ces outils sont désormais devenus inutilisables. Sans compter qu’aucune plateforme de veille ou outil de recherche professionnel ne peut se targuer de réellement surveiller Facebook.

Quand on interroge Facebook, il faut donc faire preuve de la plus grande prudence et ne pas hésiter à vérifier par soi-même la fiabilité des informations partagées.

Twitter cherche toujours la bonne stratégie

Twitter a été un peu plus épargné par les critiques, du moins pour l’instant. Pour autant, la désinformation y est bien présente et, même s’il a un peu plus tardé à communiquer dessus, Twitter a mis en place plusieurs stratégies pour lutter contre ce phénomène.

Figure 2 - Nouveau badge « original Tweeter » sur Twitter

Depuis plusieurs années déjà, on trouve tout d’abord un badge bleu « certifié » à côté de certains comptes Twitter, qui a pour but d’assurer l’authenticité d’un compte d’intérêt public.

En janvier dernier, Twitter annonçait tester un nouveau badge « Original tweeter » (voir figure 2) afin de mettre en avant qui était à l’origine d’un thread. Un thread est une série de tweets, émis par un même auteur, qui se succèdent pour former un contenu plus long. D’autres Twittos peuvent également intervenir dans ce flux. Quand un thread est très long et avec de nombreux participants, il n’est pas toujours facile de suivre et savoir qui avait commencé la discussion.

Il y a quelques jours, Twitter a également annoncé le rachat de la start-up Fabula AI qui propose une technologie de détection de fake news.

Pour autant, Twitter semble toujours chercher une solution satisfaisante : une étude publiée par Stanford en octobre dernier sur les tendances en matière de diffusion de fake news sur les réseaux sociaux indiquait que si cela baissait sur Facebook, cela continuait à augmenter sur Twitter.

Notre avis

Sur Twitter aussi, il est important de vérifier par soi-même la fiabilité des informations et des comptes et personnes qui les diffusent.

LinkedIn : nouvel espace de jeu des espions

Malgré les apparences, LinkedIn n’est pas non plus épargné par la désinformation.

On voit en ce moment fleurir de nombreux articles dans la presse indiquant que LinkedIn est devenu le nouveau terrain de jeu des espions.

Il y a quelques mois, LinkedIn avait indiqué prendre le problème très au sérieux et avoir bloqué 5 millions de comptes suspects et continué de travailler sur le sujet notamment sur un système de détection automatique de faux comptes.

Pour autant, la route est encore longue ! Il suffit de voir comme il est difficile de faire supprimer le profil d’une personne prétendant avoir travaillé dans une entreprise pour s’en convaincre.

Enfin, LinkedIn est également de plus en plus utilisé pour partager des contenus ou même en créer grâce au rachat de la plateforme Pulse il y a quelques années. Si personne ne semble s’être véritablement penché sur le sujet, il est très probable que certains internautes s’en servent pour diffuser des fake news ou fausses informations.

Quand les fake news prolifèrent sur les autres plateformes

Aucun réseau social n’est réellement épargné. Pas même Instagram qui a longtemps donné le sentiment d’être peu touché par le phénomène des fake news. De récents articles suggèrent ainsi que le réseau social est de plus en plus envahi par ce type de contenu, par exemple avec des posts publiés par des anti-vaccins. Instagram a choisi de réagir en bloquant les hashtags véhiculant des infox comme #vaccinescauseautism ou encore #vaccinescauseaids mais sans supprimer les messages.

Stephanie Otway, la porte-parole d’Instagram a ainsi récemment expliqué au micro de Poynter que :

« Notre approche en matière de désinformation est la même que celle de Facebook - lorsque nous trouvons une information erronée, plutôt que de la supprimer, nous réduisons sa diffusion »

La désinformation ne va pas disparaître

Tous les géants du Web, quels qu’ils soient sont confrontés au problème de la désinformation. Ceux qui ont été les premiers pointés du doigt comme Facebook et Google ont également été les premiers à chercher des solutions pour limiter la propagation des fake news et mieux évaluer l’information et les contenus.

A l’inverse, ceux qui ont cru être épargnés comme Instagram, Linkedin, Twitter etc. se retrouvent aujourd’hui sous le feu des projecteurs et ont donc probablement un peu de retard à combler en la matière.

Il y a et il y aura cependant toujours des contenus douteux et des sources non fiables ou des faux comptes qui apparaîtront dans les résultats d’une recherche sur le Web et sur les médias sociaux.

Il faudra toujours compter sur soi-même et sur son sens critique et éventuellement s’aider de quelques outils extérieurs pour évaluer l’information, les sources et émetteurs des informations.

Il faudra cependant suivre de près les initiatives des grands du Web et notamment les nouvelles fonctionnalités (système de badge, notations, etc.) qui pourront très certainement apporter une aide intéressante et un complément aux traditionnelles méthodes humaines.

Bulles de filtres : voie royale vers la désinformation ?

Même si l’on sort du cadre stricto sensu de la désinformation et des fausses informations, Google, Bing, Facebook et les autres sont également régulièrement accusés de maintenir les internautes dans une « bulle de filtres » en leur proposant des résultats personnalisés et donc proches de ce qu’ils ont envie d’entendre et de leurs centres d’intérêt. Ce qui peut, par là-même, faire émerger des « Fake News » si l’internaute en question est du genre à douter des médias traditionnels et croire dur comme fer à certaines théories du complot.

Dans le cas de Google, nous avons déjà eu l’occasion de montrer que la personnalisation était en réalité très légère (voir notre étude dans n°136 de NETSOURCES - septembre/octobre 2018). Pour une même requête donc, les résultats d’un internaute à l’autre diffèrent très peu.

Pour autant, les résultats d’une recherche dans Google ne fournissent qu’une vision très parcellaire d’un sujet ou une question. Tout simplement parce que Google et les autres moteurs ne donnent accès qu’à une petite partie du Web, que l’on appelait auparavant le Web visible et qui est désormais désigné comme le « Surface Web » ou Web de surface et qui ne représenterait que 4% à 5% du Web environ.

D’autre part, comme nous avons eu l’occasion de le montrer à plusieurs reprises, pour des raisons d’économies de serveurs et parce que la majorité des internautes ne vont pas au-delà de 20 résultats, Google propose de moins en moins de résultats pour une requête donnée (on dépasse ainsi rarement les 200 résultats réellement visualisables même s’il en indique plusieurs millions).

On conseillera donc de multiplier les requêtes dans différents moteurs (Bing, Yandex, SearchX, Qwant, DuckDuckGo, etc.) afin d’obtenir des résultats différents et complémentaires. Mais cela ne sera toujours par suffisant et il faudra également se tourner vers toutes les ressources du « Deep Web », serveurs, bases de données, etc pour obtenir une vision moins parcellaire.

Ce qui est le plus problématique finalement dans un contexte de veille et de recherche, ce ne sont pas tellement les résultats des moteurs de recherche mais plutôt l’affichage des flux d’information sur les réseaux sociaux comme Facebook, Twitter, LinkedIn, etc.

En effet, tous ces acteurs proposent par défaut à chaque internaute un flux d’information personnalisé qui ne reprend qu’une partie des contenus issus des comptes et utilisateurs qu’ils suivent. L’algorithme effectue une sélection d’informations en amont sans que cela ne soit très explicite.

Sur Facebook, impossible de changer les paramètres afin de voir s’afficher tous les messages publiés par ses contacts, groupes ou pages. Sur Twitter, on peut demander à « voir plutôt les tout dernier tweets » et ainsi l’intégralité des tweets publiés par les personnes que l’on suit. Sur LinkedIn, on peut également changer les paramètres mais uniquement sur la version desktop.

Dans un contexte professionnel, le risque de la sélection algorithmique n’est donc pas tellement de se retrouver face à la désinformation ou la mésinformation mais plutôt de ne pouvoir accéder réellement qu’à une infime partie des informations indexées par les moteurs ou publiés par ses sources et contacts sur les réseaux sociaux.